Los algoritmos del capital

El otro día una amiga me preguntó que era un algoritmo y me acordé la definición que me dieron en la facultad: “es una secuencia de pasos a ejecutar en orden para resolver un problema”. Esta misma tiene una trampa que me gusta hacer y consiste en no mencionar la computadora, porque en el fondo una y otra cosa no tienen nada que ver. Los algoritmos existen desde mucho antes que las computadoras. Por ejemplo, hacer café es un algoritmo:

- Calentar agua hasta que llegue a los 80 grados centígrados

- Poner 22 gramos de café molido por taza de agua en la prensa

- Verter el agua caliente en la misma

- Esperar un minuto

- Prensar

- Servir

Multiplicar, como lo aprendemos en la primaria, también es un algoritmo y uno interesante ya que hay varios: existen muchas maneras de multiplicar dos números que llevan a la misma respuesta. Algunos son más fáciles, otros más veloces, o como hacían apenas 3 décadas antes en el colegio nuestrxs progenitores, usando tablas de logaritmos. Además, es un área de investigación activa: el año pasado inventaron uno nuevo.

Cocinar es algorítmico, una receta es seguir una secuencia de pasos y hasta podríamos aplicar técnicas algorítmicas a la cocina: imaginense que las mismas digan, por ejemplo, cómo crece la complejidad con respecto a la cantidad de personas, porque son distintos los problemas de hacer un asado que los de hacer un guiso para 20 personas. Y hasta tenemos loops: “revolver hasta que …” y condicionales: “si tenemos … entonces …”.

Otro, muy antiguo: se dice que en el siglo IX durante el califato abasí se encriptaban los registros de los impuestos, por eso quizás el filósofo musulman al-Kindi diseñó un algoritmo para descifrar mensajes encriptados donde las letras estaban intercambiadas.

Mecanización

Pero, es cierto, el verdadero potencial de los algoritmos se empieza a aprovechar con el advenimiento de las computadoras. A fin de cuentas, una computadora no es más que una máquina que puede ejecutar instrucciones ordenadas de manera programable. Generalmente, se dice que la primera computadora aparece en el siglo XIX: la máquina analítica. Pero me parece más interesante hablar sobre el primer programa. ¿Qué es un programa? Pues, es un algoritmo expresado de manera que una máquina –o persona– lo pueda entender.

Vayamos entonces a la historia del primer programa. El primer programa pensado para una máquina fue escrito por Ada Lovelace (a quien pusieron a estudiar matemática porque su padre, Lord Byron, era un romántico sin salvación) en 1843 para la computadora de su amigo, Charles Babbage, que estaba diseñando la susodicha máquina analítica. Lo que resolvía el programa de Lovelace era calcular un número de Bernoulli, muy útil en la época, ya que servía para hacer multiplicaciones entre números muy grandes. El programa es bastante complejo y hasta tiene algo que lo hace, más allá de toda duda, el primer “programa real”: un bug 2. Desgraciadamente nunca lo pudieron probar ya que la máquina de Babbage jamás llegó a existir.

Lovelace, por otra parte, nunca resignó su linaje poético. En una carta a su madre le escribe enfurecida: “No me concedes poesía filosófica. ¡Invierte el orden! ¿Me darás filosofía poética, ciencia poética?”. Justamente se concebía como una pionera de la “ciencia poética”, y se dice que su amor por la poesía es en parte lo que la llevó a escribir el primer programa: un claro producto de la intersección entre el Romanticismo y la Revolución Industrial.

Con el tiempo, lo mecánico advino a lo electro-mecánico y finalmente terminamos en la computadora electrónica. Mientras la computadora de Babbage podía multiplicar dos números de 20 cifras en alrededor de 3 minutos, una computadora moderna puede hacerlo en una billonésima de segundo. Este crecimiento exponencial –ahora denominado Ley de Moore– fue observado por primera vez por Gordon Moore, uno de los fundadores de Intel, quien formuló que la cantidad de transistores 3 que entra en una computadora se duplicaría cada dos años. A efectos prácticos esto significó que diseñar algoritmos y software en general se volviese –para una clase grande de problemas– mucho más fácil: si tu programa andaba lento, podías esperar dos años para que, sencillamente por correrlo en una computadora nueva, funcione el doble de rápido.

Vale detenerse a reflexionar igual: el hecho de sacar cada dos años una computadora el doble de rápida que la anterior perpetúa uno de los efectos mas contradictorios del consumismo capitalista: la obsolescencia programada. La obsolescencia programada es una manera de aumentar las ventas de un producto diseñando el mismo de tal manera que sea obsoleto después de un tiempo artificial predeterminado. Para darnos una idea, el primer caso reconocido de obsolescencia programada es nada más y nada menos que las bombitas incandescentes: en 1925 se fundó un cartel de empresas productoras de bombitas que decidieron unánimemente limitar la vida útil de las mismas. Por lo tanto, mientras la Ley de Moore pudo significar que la “productividad” de las computadoras creció exponencialmente, también significó que millones de computadoras terminen en pilas de basura no degradable por siglos a venir.

Para bien o para mal, este proceso parece estar interrumpiéndose y ya no se espera que el crecimiento siga siendo exponencial; se estaría llegando a los límites físicos de cuánto se puede reducir un transistor.

Pero la algoritmización de la vida encuentra nuevas maneras de acelerar: la hiperconectividad de internet, la pervasividad de los smartphones, la acumulación incremental de datos personales y la subsecuente explotación: el algoritmo sigue produciendo, acaparando y no planea detenerse.

Explotación

¿Y de qué maneras los algoritmos modernos nos hacen la vida más fácil? El algoritmo de Google (PageRank), por ejemplo, nos simplifica la tarea de recordar sitios web y encontrar información en internet; EdgeRank de Facebook ordena y filtra inmensas cantidades de contenido de manera tal que nos llegue primero lo que más nos interesa; cientos de algoritmos trabajan en conjunto para que nos mandemos mensajes de texto casi instantáneos desde nuestros bolsillos.

Pero catalogar a estos algoritmos de benignos sería crudamente ingenuo. En su artículo del 2016, Cómo la Tecnología está Secuestrando Nuestra Mente, Tristan Harris desarrolla algunos de los puntos donde los algoritmos del capital nos afectan negativamente: nos hacen creer que tomamos decisiones cuando no es así, nos hacen adictos a la interacción tecnológica, potencian inseguridades sociales o físicas de tal manera que ya es tema de salud pública que las redes sociales aumentan la tasa de suicidios, y quien sabe cuantos mas.

Entonces me pregunto: si la revolución industrial –supuestamente– nos liberaba del trabajo manual, ¿los algoritmos nos deberían liberar del trabajo intelectual? Para pensar esto habría que investigar sobre qué líneas de fuga se plantan estos algoritmos. En el capitalismo estas líneas de fuga están generalmente enfocadas sobre un tipo de extractivismo económico trivial que gira alrededor de la acumulación de capital y esto es más que nunca verdad para los algoritmos.

De la misma manera que la automatización de las fábricas no liberó a la humanidad del trabajo manual, los algoritmos por sí solos no nos liberarán de las injusticias, la desigualdad, el hambre o la explotación de unos por parte de otros. Como dice Tiziana Terranova, “la automatización, desde el punto de vista del capital, debe siempre ser compensada […] con nuevas formas de controlar el tiempo y la energía así liberados. Debe producir pobreza y estrés donde debería existir riqueza y ocio. Debe hacer del trabajo directo la medida de valor aun cuando es evidente que la ciencia, la tecnología y la cooperación social constituyen la fuente de la riqueza producida” 4. Dada la realidad material del presente, sus contradicciones y la interminable desigualdad incremental que vivimos, a veces me resulta difícil entender el hype de mis colegas informaticxs por cualquier nuevo algoritmo o tecnología; siempre tan disociados del contexto social en el que se encuentran. Cuando Elon Musk anuncia que llevará 1 millón de personas a Marte antes del 2050, ¿a qué millón de personas se refiere?

Si dejásemos eso de lado, si pudiéramos olvidarnos por un momento del ímpetu capitalista de acumulación y explotación, ¿cómo serían los algoritmos desarrollados por y para personas y organizaciones sociales preocupadas por vivir en un mundo más justo para todxs?

Recuperación

En el libro Algorithms to Live By de alguna manera los autores intentan humanizar el uso práctico de algunos algoritmos, pero no es lo que uno esperaría. En vez de nuevas maneras emancipatorias de organización política y social, nos encontramos con casos aislados donde aplicar resultados estadísticos para problemas cotidianos puede ser más óptimo o eficaz. Como cuándo hay que dejar de buscar a la “pareja perfecta”, usando la regla de la secretaria que dice que en cualquier búsqueda lineal sobre un conjunto inmenso el óptimo existe en parar al haber “entrevistado” al 37% de los sujetos (si querían saber, aplicado a la búsqueda de pareja esto representa dejar de buscar a los 28 años). O que si se compran muchas verduras, la mejor manera de consumirlas es en el orden del vencimiento, excepto si algo está por vencer donde entonces se tiene que tirar “la que más comidas rinda”.

No me mueve tanto la aguja. Lo que me gustaría ver es si es posible tener algoritmos que resuelvan problemas sociales, estructurales y, por qué no, políticos.

Me viene a la mente el Proyecto Cybersyn: el plan maestro del gobierno de Salvador Allende para orquestar la economía del país, la misma ampliamente estatizada como parte de su proyecto socialista. Cybersyn hubiese consistido de una intranet entre empresas estatales que continuamente alimentaba un algoritmo que disparaba alertas y ayudaba a tomar decisiones económicas. El mismo nunca se puso en funcionamiento: el golpe de estado puso fin al sueño Chileno.

Volviendo al presente, en su charla para la CodeMesh 2019, por ejemplo, Veronica Dahl dice de pensar en una inteligencia artificial regenerativa y redistributiva. Imaginar algoritmos de machine learning que sirvan para, por ejemplo, levantar una alarma cuando una publicación científica utiliza una muestra demasiado chica o sesgada de la población. O algo más ambicioso: algoritmos que ayuden a los legisladores a tomar mejores decisiones.

Más allá de la discusión de si esto es factible o no –en la cantidad de años que el sistema judicial pueda tomar en reformarse ¿cuántas nuevas maneras de acumular habrá encontrado el capital?– comparto opinión con Terranova en que seguir desarrollando algoritmos abocados solamente a crear excedentes de tiempo y trabajo para ser apropiados por una minoría, “conduce así inevitablemente a la destrucción periódica y generalizada de la riqueza acumulada, en formas de agotamiento psíquico, catástrofe ambiental y destrucción física de la riqueza por medio de la guerra” 5.

¿Es realmente imposible pensar en algoritmos cuyo único propósito no sea acumular? No lo sé, pero creo que la búsqueda tiene el potencial de ser revolucionaria.

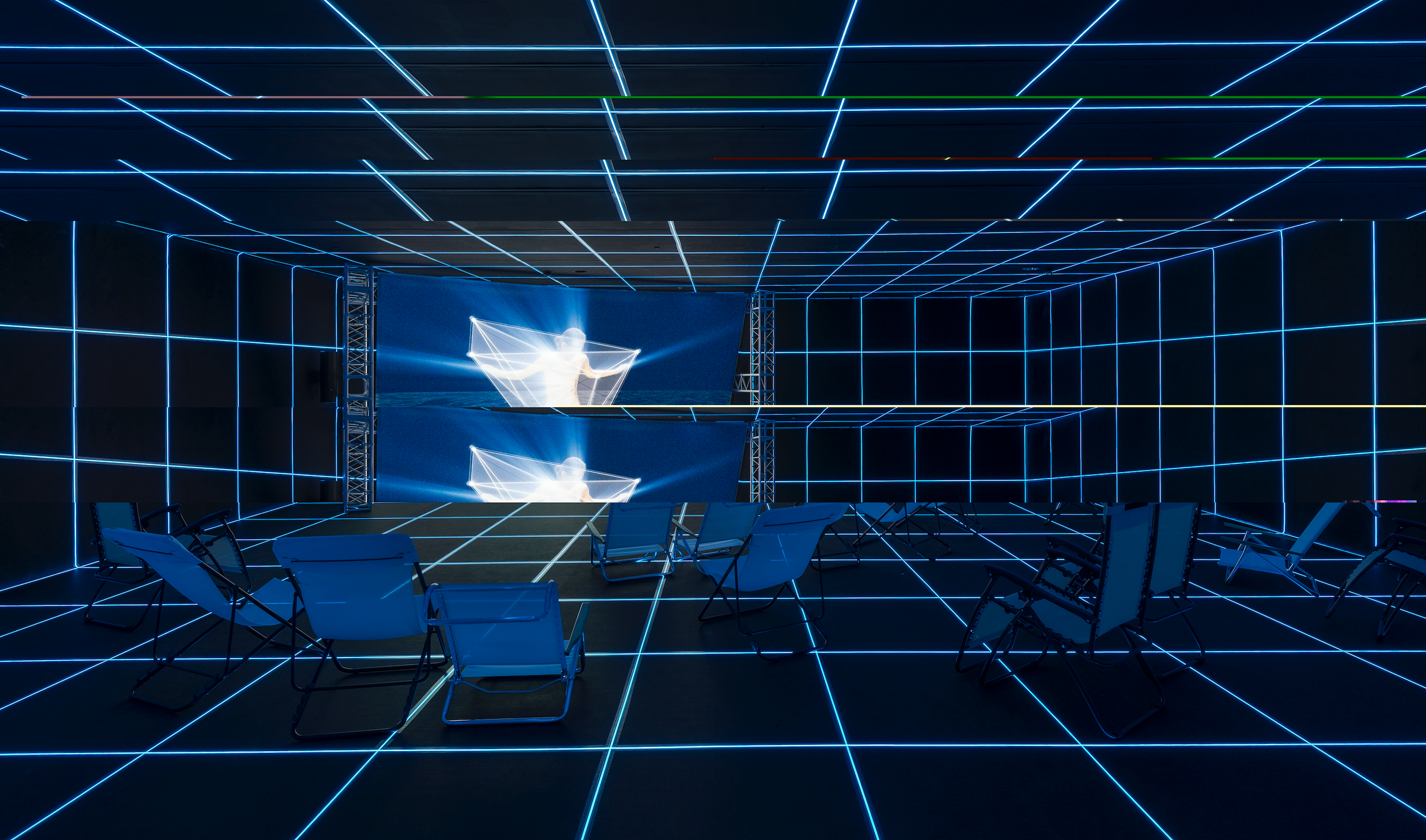

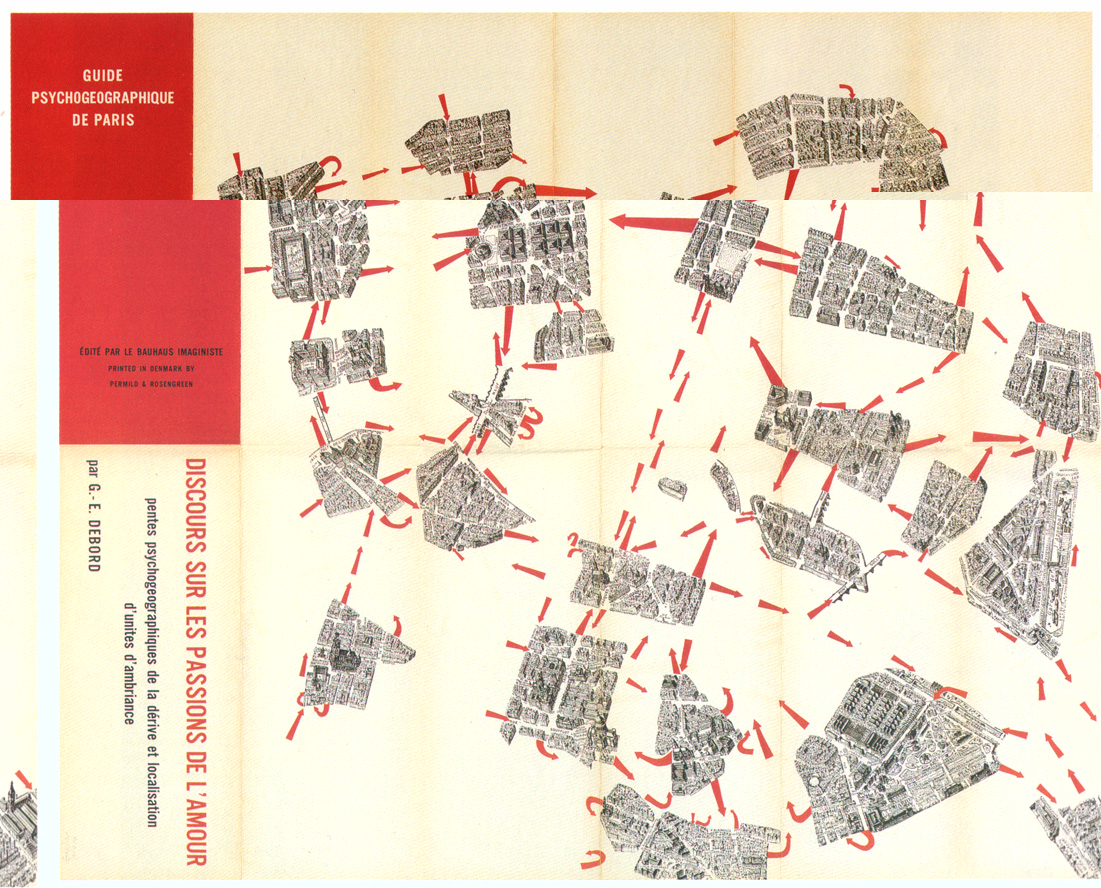

Todas las imágenes de este artículo fueron modificadas alterando su codigo binario con un editor hexadecimal. De esta manera, los efectos logrados (artefactos) son producto del algoritmo de (des)compresión JPG.↩︎

Un bug,del inglés “insecto”, es un error de programación. El término viene de una historia graciosa en la cual un programa, corriendo sobre una antigua computadora electromecánica en 1946, no funcionaba correctamente y al investigar el caso se encuentra que el error estaba causado por un insecto que se había introducido físicamente entre los contactos de un relé.↩︎

Un transistor vendría a ser la unidad básica de la que están compuestas las computadoras electrónicas: una computadora moderna tiene alrededor de 10.000.000.000 transistores.↩︎

Tiziana Terranova, Red Stack Attack!, Caja Negra, 2019↩︎

Ibíd↩︎